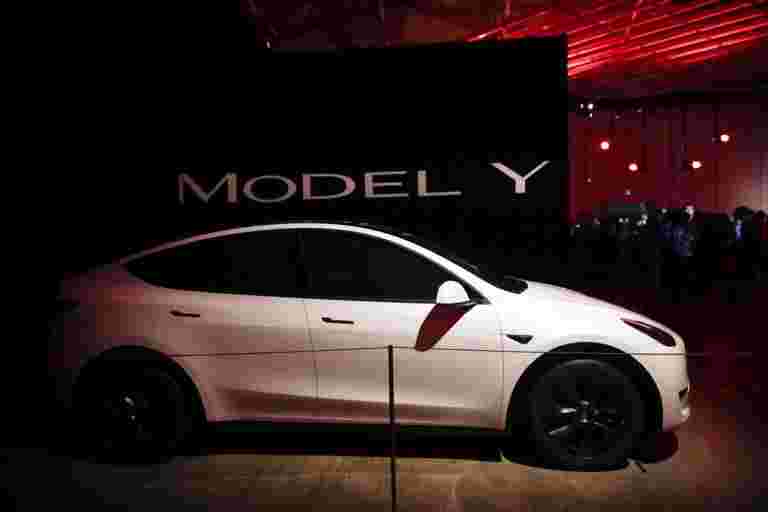

黑客迫使Tesla进入错误的车道

来源:

2021-07-02 16:03:06

黑客已经证明了他们如何通过使用称为“逆势攻击”的方法来欺骗Tesla模型S进入错误的车道,一种操纵机器学习(ML)模型的方法。

Tesla Autopilot识别车道并通过识别道路交通标志来帮助控制。

来自中国科技巨头腾讯敏锐的实验室的研究人员表明,通过在路上放置干扰贴纸,自动驾驶仪系统可以提交给迫使它产生异常判断并使车辆进入错误车道的信息。

“在这次演示中,研究人员在车辆周围调整了物理环境(例如放置在道路上或改变车道线上),以使汽车在使用自动驾驶仪时的行为方式,”Tesla发言人被引用为敏锐的安全性实验室博客。

“如果驾驶员可以通过使用方向盘或制动器可以随时容易地超越自动驾驶仪,并且应该准备好在,因此应该准备始终可以做到这一点,这不是一个真实的世界问题,并且应该准备这样做,”发言人说。

根据下载下载技术审查的报告,由于机器学习更广泛,特别是在网络安全等领域,对抗性攻击可能变得更加普遍。

声明:文章仅代表原作者观点,不代表本站立场;如有侵权、违规,可直接反馈本站,我们将会作修改或删除处理。